Thread initial par @AStrochnis :

Les passages en italique sont les retranscriptions exactes des propos de l’auteur de ce thread. Les passages en caractères romans sont mes propres ajouts et commentaires, dont je vais minimiser le nombre pour ne pas dénaturer le propos initial.

Il y a eu un erratum suite à certains propos erronés de ce thread, je le joins également en fin de billet.

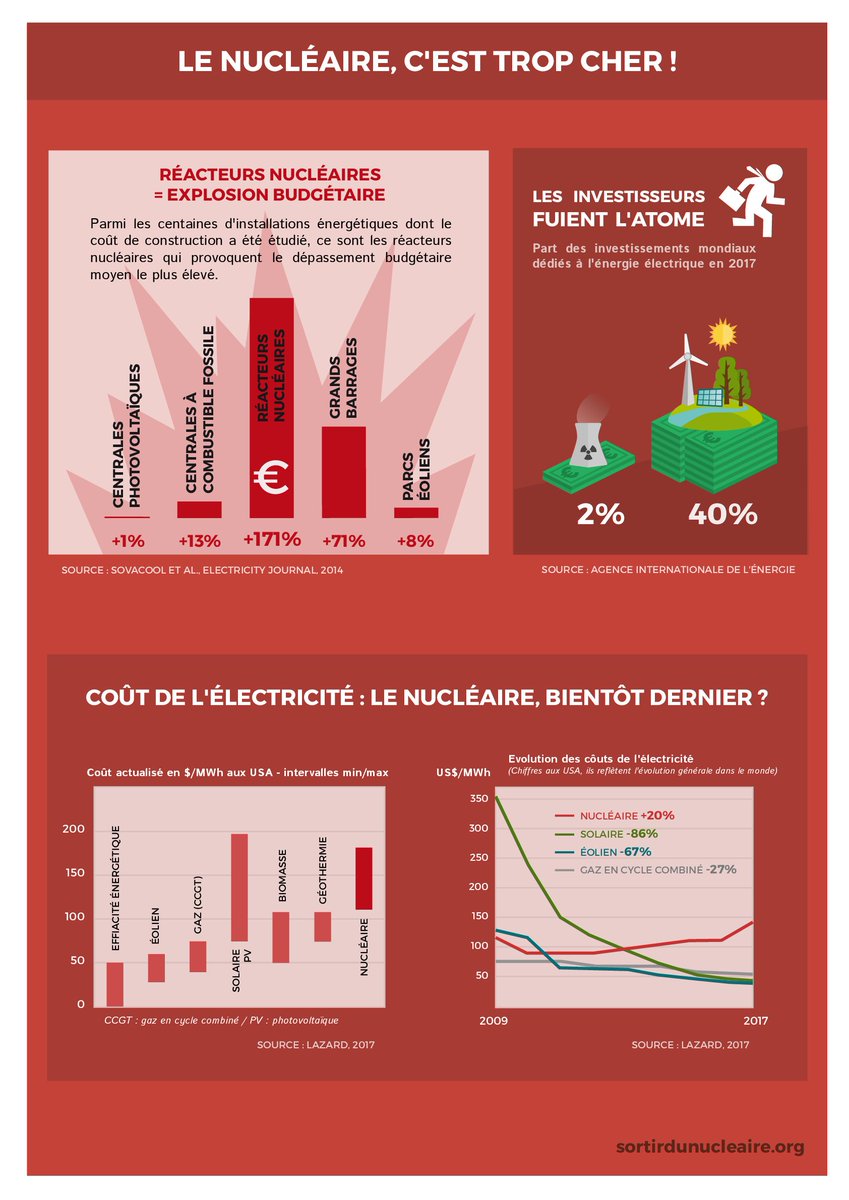

Et moi, je vais m’intéresser d’abord à cette fiche-ci. J’ai déjà commencé hier avec le petit encart en haut à gauche.

En substance, le chiffre en lui même n’est pas complètement faux, mais il faut aller voir plus loin et lire l’étude en entier. Même avec ces surcoûts, le kW installé nucléaire est moins cher que le kW installé éolien et beaucoup moins cher que le kW installé photovoltaïque.

Et encore, on ne parle que de kW installé, c’est-à-dire qu’on ne parle pas de facteur de charge, ni même de renouvellement du parc. Je rappelle qu’une centrale nucléaire est prévue pour durer 60 ans (EPR) voire même 80 ans pour les centrales américaines.

L’éolien et le PV, c’est 20 ans. C’est-à-dire que les investissement, il faudra les réaliser 3 fois pour les ENR là où une seule fois sera suffisant pour le nucléaire.

Pour plus de détail, allez voir ⬇️⬇️

Maintenant intéressons nous au bas de l’infographie, dont les données sont tirées de l’étude Lazard 2017. Pour celles et ceux qui voudraient la voir, elle est disponible ici.

Il s’agit d’une étude réalisée par la banque Lazard sur les coût des différents modes de production d’électricité aux États-Unis, et uniquement aux États-Unis. La méthode est-elle applicable en France? À priori je dirai non, déjà pour une raison énoncée en page 3 de l’étude :

« Does not reflect decomissioning costs or potential economic impact of federal loan guarantees or other subsidies. Low and high end depicts an illustrative nuclear plant using the AP1000 design. »

Outre le fait que le démantèlement n’est pas compté (mais il ne l’est pour aucun moyen de production), le souci est que les réacteurs sont des AP1000, qui ne sont pas utilisés en France, et je ne suis pas sur que ces coûts soient utilisables tels quels. Mais ce n’est pas le pire.

En page 2, qui est le graphe représenté par @sdnfr, il est un petit incipit, qu’ils ont visiblement oublié de lire, et que je vous livre :

« Certain Alternative Energy generation technologies are cost-competitive with conventional generation technologies under some scenarios; such observation does not take into account potential social and environmental externalities (e.g., social costs of distributed generation, environmental consequences of certain conventional generation technologies, etc.), reliability or intermittency-related considerations (e.g., transmission and back-up generation costs associated with certain Alternative Energy technologies) »

Et oui, les jolis chiffres présentés par @sdnfr traduisent, une fois de plus, le coût d’énergie installée, et non réel. En prenant un facteur de charge de 23% pour l’éolien et de 70% pour le nucléaire, on passe à des fourchettes de 130 à 260 $/MWh pour l’éolien et 160 à 261 $/MWh pour le nucléaire. [Voir à ce sujet l’erratum en bas de page]

Je rappelle également que compte tenu des durées de vie, il faudra refaire certains investissement. Sur 60 ans par exemple, les investissement fixes (hors combustibles donc) seront faits une seule fois [pour le nucléaire] contre trois fois pour le vent.

Ce qui donne donc un coût du MWh éolien trois fois plus cher que celui du nucléaire.

Je rappelle également que compte tenu des durées de vie, il faudra refaire certains investissement. Sur 60 ans par exemple, les investissement fixes (hors combustibles donc) seront faits une seule fois [pour le nucléaire] contre trois fois pour le vent.

Ce qui donne donc un coût du MWh éolien trois fois plus cher que celui du nucléaire.

Chers amis de @sdnfr, il va falloir apprendre à lire plus consciencieusement les études. J’espère que vous n’avez pas externalisé cette prestation, sinon vous vous êtes fait escroquer.

Dernier point, il est question également dans l’étude question d’émission de CO2 en comparaison avec des centrales à charbon (on rappelle qu’ils en prennent pas en compte l’intermittence). Ça me rappelle le rapport du GIEC sorti il y a deux jours, vous savez celui où divers mix électriques sont testés pour pouvoir contenir le réchauffement à 1,5 °C, dans lesquels certes les ENR croissent entre 40% et 70% par rapport à 2010, mais où également la part du nucléaire double voire quintuple. Une petite réaction @sdnfr?

Ou alors c’est comme pour le reste, vous faites du cherry picking sans vous soucier des hypothèses.

Ah oui, et concernant le graphe en haut à gauche de votre infographie, concernant les investissement.

C’est aussi de l’escroquerie intellectuelle.

L’investissement se fait parce qu’il y a un tarif de rachat garanti et un bénéfice garanti pour le client. C’est la subvention qui génère l’investissement. Arrêtez les subventions, et vous verrez qu’on investira beaucoup moins dans les ENR.

Et sinon, [dans le prochain thread/billet] je reviens vous parler d’une autre de leurs fiches, qui présente l’Allemagne comme LE modèle à suivre, et qui est aussi truffée de mensonges.

Bisou .

Erratum :

J’ai commis deux erreurs : concernant les facteurs de charge, et les coûts relatifs aux durées de vie.

Je pensais que Lazard avait travaillé sur la puissance installée. En fait non, les facteurs de charge utilisés étaient de 90% pour le nucléaire et 50% pour l’éolien. Pour l’actualisation, j’avais bêtement multiplié par trois les coûts éoliens car ne elles durent que 20 ans.

J’ai donc repris les données d’entrées de Lazard et appliqué à nos « spécificités françaises », sur les facteurs de charge et la durée de vie des installations. Mes nouvelles hypothèses sont donc les suivantes. Pour l’éolien, 23% et 20 ans. Le nuc, c’est 67% et 60 ans.

Pour le solaire, c’est 18% et 30 ans. A noter que Lazard avait initialement pris 40 ans pour la durée de vie d’une centrale. Pour les coûts, j’ai pris les chiffres des pages 18, 19 et 20 de l’analyse Lazard.

Total Capital cost pour l’investissement , fixed et variable O&M pour les coûts d’exploitation, et les coûts de combustible pour le nuc. J’ai aussi pris pour hypothèse, comme Lazard (page 17), que les coûts d’exploitation augmentaient de 2,25% chaque année (O&M escalation rate).

Je n’ai pris que ces données-ci pour calculer un coût total durant l’exploitation du parc et ramené à un coût moyen par MWh. Je tiens également à disposition mes fichiers excel si besoin. [Contactez @Astrochnis sur Twitter pour ça]

Il s’agit donc de calculs hors coûts de réseau, de démantèlement et de gestion d’intermittence. Je n’ai pas regardé, dans un premier temps, les coûts de remplacements des parcs. Et il s’agit uniquement de déterminer les coûts bruts des différentes filières, pas de prendre en compte la fiscalité ou le financement.

Voici le premier résultat auquel je suis arrivé. Le nucléaire reste donc légèrement plus cher que l’éolien, dont acte. Et le solaire beaucoup moins cher.

Les écarts de ces résultats par rapport à l’étude initiale sont principalement dues aux variations de facteurs de charge, qui augmente substantiellement le coût de l’éolien. La baisse du coût du nucléaire vient de la durée de vie.

L’hypothèse américaine était d’une exploitation de 40 ans, j’ai pris 60.

Mais j’avais quand même l’impression de comparer des choux et des carottes du fait que les parcs avaient des durées de vie différentes. J’ai donc voulu calculer les coûts des remplacements des parcs en formulant plusieurs hypothèses : les coûts O&M continuent d’augmenter au rythme de 2,25% par an, et les besoins en investissement pour réinstaller les parcs sont les mêmes. C’est-à-dire que si à l’instant T on a besoin de 1000$ pour installer une éolienne,dans 20 ans on aura aussi besoin de 1000$.

Les facteurs de charges sont pris inchangés (hypothèse discutable, mais je n’ai pas d’infos sur ce qu’ils pourraient être dans 20 ou 40 ans). Et j’ai pris deux scénarios : les investissements nécessaires sont provisionnés ou pas. Provisionnés, cela signifie que les capitaux nécessaires aux remplacement existent dès le début du projet, mais sont placés de manières à être utilisés dans 20, 30 ou 40 ans. Pour les taux d’actualisation, je me suis basé sur la Banque de France.

J’ai donc pris la moyenne arithmétique des valeurs des TEC 20 et 30 ans sur les 12 derniers mois, soit 1,3% pour 20 ans et 1,66 pour 30 ans. Comme je n’ai pas trouvé de TEC 40 ans, j’ai pris arbitrairement 2%. Cela signifie en gros pour pour remplacer le parc éolien dans 20 ans, j’aurai besoin d’une somme entre 1200 et 1600 $/kWh, et que ça revient à disposer aujourd’hui de sommes entre 926 et 1273 $/kWh…

Et j’ai appliqué ces formules pour le renouvellement du parc solaire au bout de 30 ans, et deux renouvellement de parc éolien à 20 et 40 ans. Et voici le résultat :

Et j’ai aussi fait la même chose si les réinvestissements n’étaient pas provisionnés, dès le début.

Donc en synthèse, si on tient compte des remplacement de parc pour maintenir la production électrique, le nucléaire et l’éolien ont des coûts similaires, le solaire étant moins cher.

Et en conclusion, l’étude de @sdnfr reste quand même foireuse.

Au passage, dernier point sur cette étude de @sdnfr. Ils ont précisé que l’étude Lazard était applicable au reste du monde.

Seulement, le levelized cost of energy, tel que calculé par Lazard, dépend des taxes appliquées, et a pris pour hypothèse un amortissement sur 20 ans pour toutes les technologies (voir page 17 de l’étude). Donc non, ce n’est pas un modèle applicable en dehors des Etats-Unis.