Ce billet est une reprise d’un thread pour revenir sur un sujet qui a fait l’objet de nombreux commentaires dernièrement : le fonctionnement des réacteurs nucléaire au-delà de leur quarantième année de service.

Préambule

Il se dit, essentiellement chez les opposants au nucléaire, que les centrales ont été conçues pour un maximum de 40 ans, après quoi elle doivent nécessairement être mises à l’arrêt.

Alors, immanquablement, quand l’Autorité de sûreté nucléaire dit qu’un fonctionnement jusqu’à 50 ans est envisageable sous des conditions qu’elle précise, les opposants hurlent au complot, à la connivence entre l’Autorité et les industriels au mépris de la santé humaine.

Mais si ce n’est pas 40 ans la limite, quelle est-elle ? D’où vient-elle ? Qui la fixe ?

J’avais déjà proposé des éléments explicatifs à ce sujet dans un précédent article. Complétons donc…

Non, ce nombre de 40 ans ne sort pas d’absolument nulle part. Il existe effectivement une durée de service prise comme hypothèse à la conception, laquelle sert de base au dimensionnement pour les ingénieurs qui y travaillent, car on ne peut naturellement pas leur demander de concevoir quelque chose qui durera indéfiniment : ils eurent une durée cible à prendre en considération.

Celle-ci fut de 25, 30 ou 40 ans selon les réacteurs et les époques. Mais un ingénieur ne conçoit pas un équipement pour qu’il fonctionne au maximum le temps prévu dans le cahier des charges, c’est une évidence, non ? C’est une durée minimale ! Et, compte tenu des marges prises à la conception, qui sont généralement larges dans l’industrie, très larges dans l’industrie de l’époque, extra-larges dans l’industrie nucléaire de l’époque (faute des moyens de calculs poussés dont nous disposons aujourd’hui), ce minimum peut tout à fait, en théorie, être dépassé.

Au-delà des 40 ans

En pratique, cela exige tout de même une maintenance, une surveillance, des études et des justifications, et c’est ce qu’exigent les autorités de sûreté dans tous les pays avant d’autoriser toute extension de durée de service. Des réacteurs dont on attendait 40 ans de fonctionnement initialement sont déjà autorisés à continuer jusqu’à 60 ans; par exemple aux USA. Les exploitants d’une poignée de réacteurs, dans ce pays, ont même déjà fourni les éléments à l’autorité de sûreté locale pour obtenir une autorisation de service jusqu’à 80 ans, et le processus a été initié pour de nombreux autres réacteurs. À ce jour, le maximum à retenir serait plutôt 80 ans que 40, donc.

Et si Greenpeace transforme un minimum de 40 ans en maximum, ne faisons pas la même erreur : 80 ans est bien un maximum, réglementaire (et donc jusqu’à preuve du contraire), ce qui ne veut pas dire que tous les réacteurs pourront atteindre cet âge. Un réacteur, c’est une machine extrêmement complexe, composée de centaines ou milliers de km de tuyauteries, câbles, et des centaines de robinets, de pompes, de composants divers.

La totalité moins deux de ces équipements est remplaçable.

Donc à ces deux exceptions près, sous condition d’une maintenance appropriée, la durée de service théorique d’un réacteur nucléaire est infinie. Ces deux exceptions sont l’enceinte de confinement et la cuve. Et, dans la pratique, la limitation la plus sévère est la cuve. La cuve, c’est un élément du « circuit primaire », un cylindre d’une douzaine de mètres de long pour quatre de large, dans laquelle l’eau circule de bas en haut en rencontrant le combustible, le cœur du réacteur, où l’énergie de la réaction nucléaire est transmise à l’eau qui s’échauffe alors.

La cuve est exposée à un flux intense de neutrons en provenance du cœur, qui en dégrade les propriétés mécanique : tenue aux chocs mécaniques, aux chocs thermiques, à la pression… Et on doute franchement de pouvoir la remplacer si besoin. D’où le fait qu’elle soit la limite pratique à la durée de service d’un réacteur.

Et c’est en modélisant la dégradation de ses propriétés mécaniques au fur et à mesure de son irradiation que les concepteurs de nos réacteurs ont estimé la durée de service desdits réacteurs. En modélisant. Dans les années 60.

Aujourd’hui, on connaît plutôt bien l’état des cuves. Il « suffit » d’analyser (c’est loin d’être simple, mais ça se fait). Et, évidemment, on connaît de manière plus fiable les cuves dans leur état actuel… Que les ingénieurs ne l’estimaient. Ça peut sembler stupidement évident, mais c’est un véritable sujet : aux yeux de certaines personnes, il vaudrait mieux faire confiance, pour connaître l’état actuel de nos cuves, aux concepteurs d’il y a cinquante ans qu’aux analystes aujourd’hui ; les estimations seraient plus fiables que de simplement constater. Mystère.

Quelles différences entre la conception et aujourd’hui ?

L’on peut discuter de quelques exemples d’hypothèses, faites à l’époque, alors totalement légitimes, mais qu’il est tout aussi légitime de rejeter ou de questionner aujourd’hui. Et l’invalidation de ces hypothèses contribue à expliquer que les durées de service augmentent par rapport aux estimations initiales.

Les marges

Il y en a un jeu d’hypothèse qu’il est très simple de remettre en question, ce sont toutes celles liées aux marges de calcul. Les modèles simples de l’époque, par rapport aux simulations numériques d’aujourd’hui, ce n’est pas la même affaire. Ils connaissaient la plupart des limites de leurs modèles, les imprécisions de leurs calculs, les simplifications qu’ils devaient adopter. Et en ingénieurs compétents et conscients, ils compensaient ces approximations par des marges. Les marges d’erreurs aujourd’hui sont plus fines, puisque l’on a une connaissance bien plus pointues du comportement des aciers sous irradiation. Et l’on a donc « du mou », une marge historique dont on n’a plus la nécessité aujourd’hui.

Ce gain sur les marges d’erreur est en partie « consommé » par des exigences de sûreté plus sévères aujourd’hui. Autrement dit, une partie de la marge d’erreur a été convertie en marge de sécurité : on envisage des scénarios beaucoup plus contraignants, pour les matériaux par exemple, qu’à l’origine, et donc les marges historiques nous permettent de justifier que ces scénarios plus contraignants sont gérables.

Et ce gain sur les marges d’erreur est également en partie du temps gagné sur la durée de service de la cuve.

Le taux d’utilisation

Un autre exemple d’hypothèse à revoir, c’est celle sur la quantité d’énergie produite.

Je n’ai pas fait mes exercices de bibliographie pour connaître quelles hypothèses exactes étaient considérées. Mais il ne me paraît pas déraisonnable d’imaginer qu’à la conception, on s’attendait à ce qu’un réacteur fonctionne en moyenne (donc, compte tenu des arrêts planifiés ou imprévus) à 90% de sa capacité, et ce pendant 40 ans. Autrement dit, qu’un réacteur de 900 MW (ils représentent la majorité du parc français aujourd’hui, avec 32 réacteurs sur 56) produirait 284 TWh d’électricité en 40 ans.

Or, la production électrique est directement liée à la production d’énergie nucléaire ayant eu lieu dans la cuve, et donc au nombre de fissions, et donc au nombre de neutrons émis, et donc à l’irradiation accumulée par la cuve (provenant notamment des neutrons). Donc un réacteur qui a moins produit, c’est, toutes choses égales par ailleurs, une cuve qui a moins été irradiée, et a donc moins vieilli.

Si, dans la pratique, le réacteur a passé plus de temps qu’attendu à l’arrêt, ou s’il a du faire du suivi de charge, c’est à dire faire varier sa puissance pour s’adapter à la demande, sa capacité a pu n’être utilisée qu’à 75% en moyenne, par exemple. La production électrique en 40 ans s’est alors établie à 237 TWh. Par rapport à la prévision initiale de 284 TWh, il reste donc 47 TWh à produire ; soit 8 ans de service à raison de 6 TWh par an.

La géométrie du cœur

Encore une hypothèse de conception que la réalité n’a pas respectée.

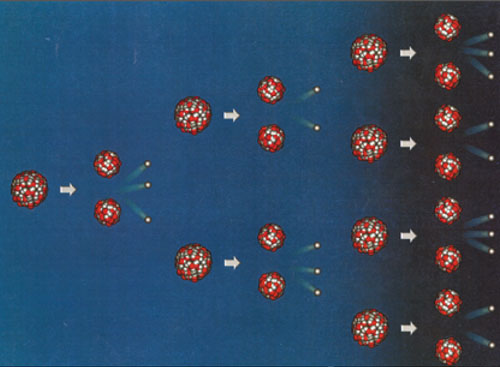

Typiquement, on renouvelle le cœur d’un réacteur à raison d’un tiers tous les ans. Donc le combustible passe, au total, 3 ans en cuve.

Plus il est vieux, moins le combustible possède d’éléments fissiles (uranium 235), et plus il contient de produits de fission qui absorbent les neutrons et donc réduisent la réactivité, l’efficacité du combustible. Pour compenser, on met le combustible neuf en périphérie du cœur, et à chaque rechargement, on le rapproche du centre du cœur parce qu’il a vieilli. Donc, la première année, il est sur l’extérieur, la deuxième année, il est sur une couronne intermédiaire et la troisième année, il la passe en plein milieu du cœur.

Et chaque année, on sort le combustible qui est en plein milieu, usé, on décale tout, on met du combustible neuf en périphérie, et on repart pour un an. C’est très schématisé, mais c’est l’idée. Quel rapport avec l’usure de la cuve ?

C’est le fait de mettre le combustible neuf, le plus réactif, et donc le plus gros émetteurs de neutrons – irradiants pour la cuve, je le rappelle – en périphérie, au plus proche des parois de la cuve. Celle-ci est donc d’autant plus fortement irradiée… Et c’est quelque chose que l’on avait bien identifié à la conception.

Mais entre temps, on s’est mis à faire une sorte de panachage du combustible neuf / un peu vieilli / très vieilli, pour trouver le meilleur compromis possible entre optimisation de l’utilisation du combustible et usure de la cuve. Et la conséquence, c’est que l’on gagne encore des années. Attention toutefois, l’utilisation, dans certains réacteurs, de combustible MOX (combustible recyclé à base de plutonium) a l’effet inverse, et a limiter le gain obtenu par le changement d’agencement du combustible dans le cœur.

Les transitoires

Un dernier exemple d’hypothèse de conception, le nombre de transitoires, doux ou rapides, subis par la cuve. Un transitoire, c’est un changement, plus ou moins brutal, des conditions de fonctionnement. Typiquement, une variation de pression ou de température, d’autant plus nocive à l’intégrité du circuit qu’elle est brutale.

Ces transitoires sont, autant que possible, limités en ampleur et en vitesse en fonctionnement normal, mais pas inévitables. Et ils sont à compléter des arrêts d’urgence pour des incidents et accidents.

Dans les études de conception, les ingénieurs d’alors ont pris en considération ces transitoires, avec des hypothèses, par exemple d’un à deux arrêts d’urgence par an et par réacteur. Valeur qui fut vérifiée pendant des années, mais aujourd’hui, la moyenne est plutôt autour de 0,5 arrêt d’urgence par an et par réacteur. Donc moins de stress mécanique pour le circuit primaire, et des années de gagnées.

Les limites ne sont pas que techniques

Les éléments présentés depuis le début de cet article sont à considérer sous condition d’une maintenance appropriée de tous les autres équipements du réacteur, voire leur remplacement périodique. Or, la maintenance a un coût, qui peut, à la longue, être élevé.

Et c’est pour ça que, dans la pratique, ce qui détermine quasiment toujours la fin de vie d’un réacteur, ce n’est rien de tout ce que je viens de vous expliquer. Ce peut être un accident, mais le plus souvent, c’est une décision politique (Fessenheim, Allemagne…) ou une décision économique. Car, quand la maintenance pour garder en service un réacteur coûte plus cher que ce que le réacteur rapporte en vente d’électricité… Alors c’est souvent une bonne raison pour son propriétaire ou exploitant de décider de son arrêt définitif.

Ce fut le destin de pas mal de réacteurs aux États-Unis en particulier, d’autant plus aux USA, il y a deux facteurs de complications pour la rentabilité des réacteurs nucléaires : le boom du gaz de schiste qui tire les prix de l’électricité vers le bas, et donc réduit la rentabilité des réacteurs, et les centrales qui comptent 1 seul réacteur, moins rentables que lorsqu’elles en comptent 2 ou plus, pour des raisons de mutualisation des compétences et matériels.

Conclusion

À l’issue de cet article, vous connaissez les trois principaux signaux indiquant la fin de vie d’un réacteur nucléaire :

- Une décision politique en ce sens.

- La non-rentabilité.

- L’usure excessive de la cuve.

Et aucunement quelque chose d’aussi grossier que le nombre des années, contrairement aux allégations trompeuses de petits hommes verts.

Démystification rapide

Greenpeace France propose 10 raisons, selon eux, de fermer une centrale nucléaire après ses 40 ans. À la lumière des éléments présentés dans cet article, répondons-y…

« Les centrales nucléaires n’ont pas été conçues ni testées pour durer plus de 40 ans »

Conçues non, mais testées si, au regard de toutes les centrales déjà autorisées à fonctionner plus (dont certaines approchent déjà les 50 ans).

« Les centrales nucléaires, leurs matériaux et leurs équipements vieillissent mal, ce qui affecte la performance des réacteurs. »

La performance affecte la production et donc la rentabilité économique. Si les exploitants souhaitent prolonger un réacteur, c’est que celui-ci est rentable. Lorsqu’il ne l’est pas, soit ils font ce qu’ils peuvent pour qu’il le redevienne, soit ils le mettent à l’arrêt, ça s’est déjà vu.

« Certains composants essentiels s’abîment mais ne sont pas remplaçables. »

Cela induit que la durée de service n’est pas infinie. Pas qu’elle est de 40 ans.

« Les réacteurs nucléaires souffrent aussi d’anomalies et de défauts de fabrication. »

Connus, suivis, et qui peuvent évoluer jusqu’à avoir rogné les marges de sûreté et donc conduire à exiger l’arrêt définitif. Décision qui appartient à l’ASN, mais qui n’est pas conditionnée à un âge, ce serait absurde.

« Les réacteurs ont été imaginés dans les années 1970 et 80 »

Ce qui veut dire qu’ils ont bénéficié de 50 ans de suivi, de retour d’expérience international, d’évolutions matérielles et organisationnelles. Et donc qu’on les connaît bien mieux aujourd’hui qu’à l’époque. Je rappelle qu’au titre de ce suivi, en France, chaque installation nucléaire fait l’objet d’une réévaluation complète de sa sûreté entre l’exploitant, l’ASN et l’IRSN, pour s’assurer de sa conformité aux standards de sûreté en vigueur (et pas seulement ceux à la conception).

« Les vieilles centrales ne seront jamais aux normes les plus récentes. »

Si, cf. tweet précédent. Aux normes les plus récentes qui leurs sont applicables, pas aux normes des réacteurs neufs. Pour avoir des réacteurs neufs, il faut construire des réacteurs neufs.

« Tous les ans, EDF demande des dérogations pour contourner les normes de sûreté. »

Et soit fournit les justifications auprès de l’ASN pour les obtenir, donc en proposant des moyens palliatifs permettant d’un côté de gagner en sûreté ce qu’ils perdent de l’autre, soit n’obtient pas ces dérogations.

« Le risque d’accident grave augmente. »

Non, Greenpeace confond tout simplement le fait qu’on identifie de plus en plus de sources de risques au fil des années (retour d’expérience, consolidation des connaissance…) avec une prétendue augmentation du nombre de ces sources. Comme je le mentionnais précédemment, une réévaluation de sûreté décennale est pratiquée pour s’assurer de la conformité aux standards en vigueur -> le risque d’accident grave diminue au fil du temps. Par exemple avec le retour d’expérience post-Fukushima.

« Les centrales polluent l’environnement au quotidien. »

Propos qui ne brille que de sa vacuité et ne mérite pas débat : on se doute qu’ils étaient à la peine pour arriver à 10 arguments). Je vous propose de juste admettre, dans le cadre de cet article, que c’est éventuellement un argument contre le nucléaire, mais sans rapport avec une limite à 40 ans.

« Prolonger la durée de vie des réacteurs, ça coûtera cher et on ne sait pas encore combien. »

Le processus d’échange tripartite entre l’ASN, l’IRSN et EDF est continu, donc si, on sait de manière relativement précise combien ça va coûter, et c’est clairement rentable. Et c’est clairement admis dans le monde entier, cf. cet extrait piqué à l’Agence internationale de l’énergie.

Policy and regulatory decisions remain critical to the fate of ageing reactors in advanced economies. The average age of their nuclear fleets is 35 years. The European Union and the United States have the largest active nuclear fleets (over 100 gigawatts each), and they are also among the oldest: the average reactor is 35 years old in the European Union and 39 years old in the United States. The original design lifetime for operations was 40 years in most cases. Around one quarter of the current nuclear capacity in advanced economies is set to be shut down by 2025 – mainly because of policies to reduce nuclear’s role. The fate of the remaining capacity depends on decisions about lifetime extensions in the coming years. In the United States, for example, some 90 reactors have 60-year operating licenses, yet several have already been retired early and many more are at risk. In Europe, Japan and other advanced economies, extensions of plants’ lifetimes also face uncertain prospects.

Economic factors are also at play. Lifetime extensions are considerably cheaper than new construction and are generally cost-competitive with other electricity generation technologies, including new wind and solar projects. However, they still need significant investment to replace and refurbish key components that enable plants to continue operating safely. Low wholesale electricity and carbon prices, together with new regulations on the use of water for cooling reactors, are making some plants in the United States financially unviable. In addition, markets and regulatory systems often penalise nuclear power by not pricing in its value as a clean energy source and its contribution to electricity security. As a result, most nuclear power plants in advanced economies are at risk of closing prematurely.

Bref. Une fois n’est pas coutume, on cherchera en vain la vérité dans la communication de Greenpeace. De la démagogie, de l’appel à l’émotion, des arguments foireux qui défient la technique, et répéter en boucle les mêmes inepties pour établir une sorte de vérité alternative qui leur sied davantage, voilà ce qu’ils ont à offrir…